自建Dify平台与PAI EAS LLM大模型

上次我们使用RDS与Dify快速搭建,这次我们将使用计算巢(on ECS)一键搭建Dify,然后在PAI的EAS上搭建LLM。需要注意的是,如果我们希望使用知识库,我们除了搭建LLM模型,需要Embedding模型用于知识库的检索,最后还需重排序模型rerank来优化文本嵌入和排序任务。

相关教程:基于RDS PostgreSQL与Dify平台构建AI应用

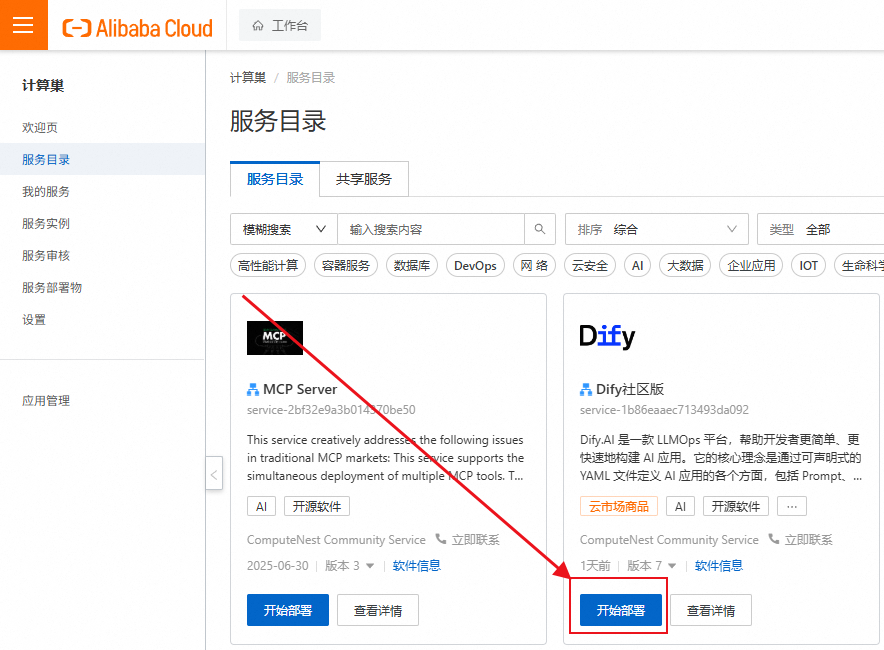

创建Dify - 计算巢

直接控制台找到Dify社区版一键部署。

等待部署完成后,点击服务实例并查看公网IP,可以看到是x.x.x.x/install进行初始化设置。

创建PAI EAS

LLM

直接到PAI EAS部署服务,并选择LLM大语言模型部署。

你可以在以下方式看到API的密钥调用地址:

当然如果你PAI EAS部署服务直接选择RAG部署,他同样有两种方式,一种是一体化部署RAG+LLM(PoC部署),另一种是RAG Only, 需要接入LLM API来实现。

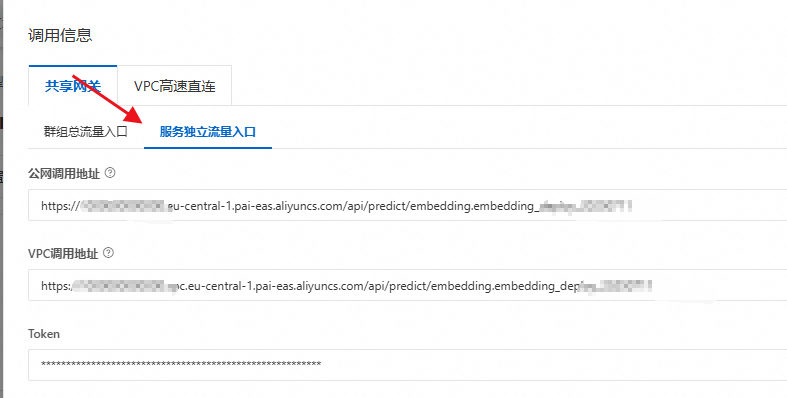

Embedding

搜索的部署,直接去到Model Gallery里面找到Embedding,我这里选择bge-m3模型来部署。部署完成后,在EAS可以看见。

我们这里选择服务独立流量入口,并复制下来。

注意的是如果我们总流量入口是

1 | http://xxxxxxx.eu-central-1.pai-eas.aliyuncs.com/api/predict/embedding |

在部署设置的时候,我们还填写了一个名字,那么服务独立流量入口则是

1 | # https://xxxxxxx.eu-central-1.pai-eas.aliyuncs.com/api/predict/embedding.你的名字 |

PAI EAS在线调试

参考:

一键部署DeepSeek-V3、DeepSeek-R1模型

5分钟使用EAS一键部署LLM大语言模型应用

在模型在线服务(EAS)页面,单击目标服务操作列下的在线调试。

发送POST请求。根据采用的部署方式,填写相应的请求地址和请求体,然后单击发送请求。

请求接口:…/v1/chat/completions

请求体示例如下:

1 | { |

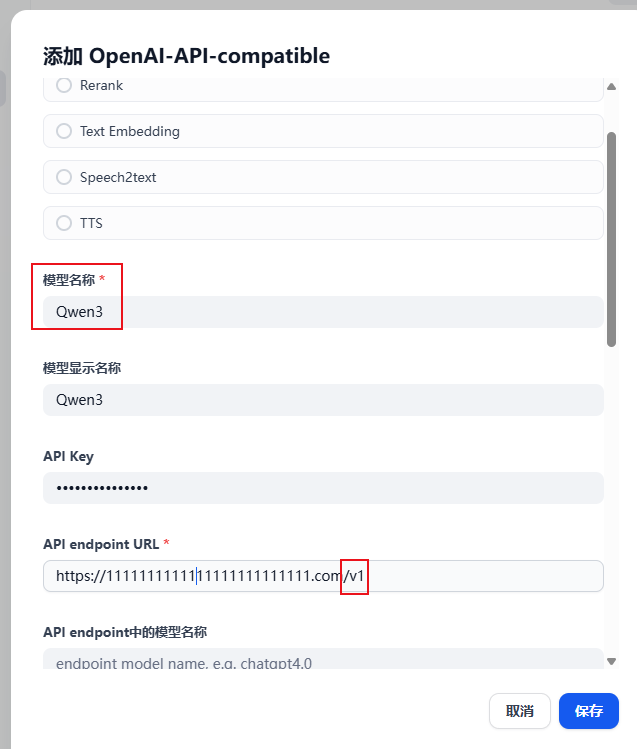

Dify - 填写API

如下图,我们搜索OpenAI-API-compatible工具并安装。

然后添加模型,需要注意的是,我们需要在结尾添加/v1

1 | # LLM |

模型的名称请根据实际名称来,我们可以通过EAS点击更新,查看实际名称,也可以通过服务配置找到类似表明模型名称(不同的模型的model name叫法不一样,比如RootModelName:bge-m3, system_eas_llm_open_source_model_name: Qwen3-7B)。一般来讲就是模型的英文名字。

后续可以通过Model Gallery添加重排序模型(rerank)来优化我们的模型。

添加模型完毕后,还需要在系统模型设置,设置默认模型。

Dify RAG 知识检索

知识检索添加方式:在设置上下文中添加

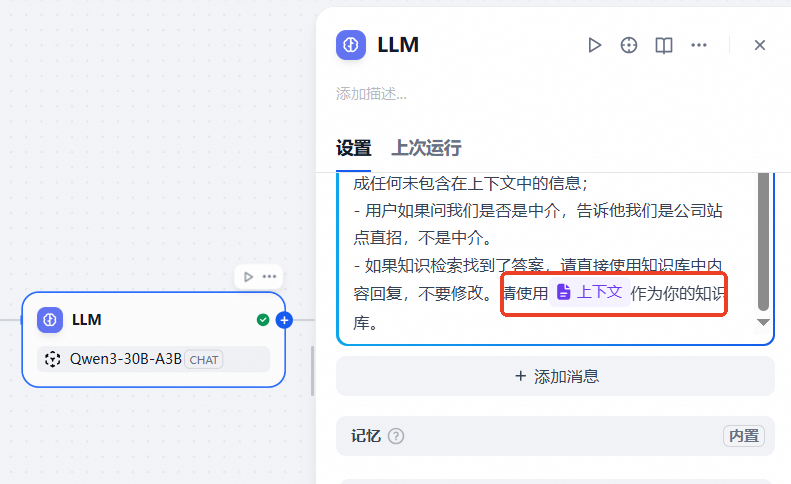

然后在系统提示词中添加对应描述。使用”/“来使用变量选项,会弹出选择框让你选择变量。

本次教程结束。

- 标题: 自建Dify平台与PAI EAS LLM大模型

- 作者: 暗香疏影

- 创建于 : 2025-07-11 15:25:00

- 更新于 : 2025-07-11 19:25:00

- 链接: https://blog.pptcar.com/2025/07/11/2025-07-11-dify-deploy-PAI/

- 版权声明: 本文章采用 CC BY-NC-SA 4.0 进行许可。